2023 年是大型語言模型蓬勃發展的一年,在上半年有 Meta AI 推出的 LLaMA,下半年則有 LLaMA 2 與 Mistral AI 推出的 Mistral 及 Mistral 模型,而這些語言模型主要都是以Transformer 架構來開發的,直至 2023 年 12 月新架構 Mamba 的推出,被認為有機會可以取代現有的 Transformer 架構。

這篇文章將帶你認識何謂 Mamba 架構,以及它是否有機會成為未來的主流發開架構,以及其在 AI 產業中的潛在影響。

富果觀點

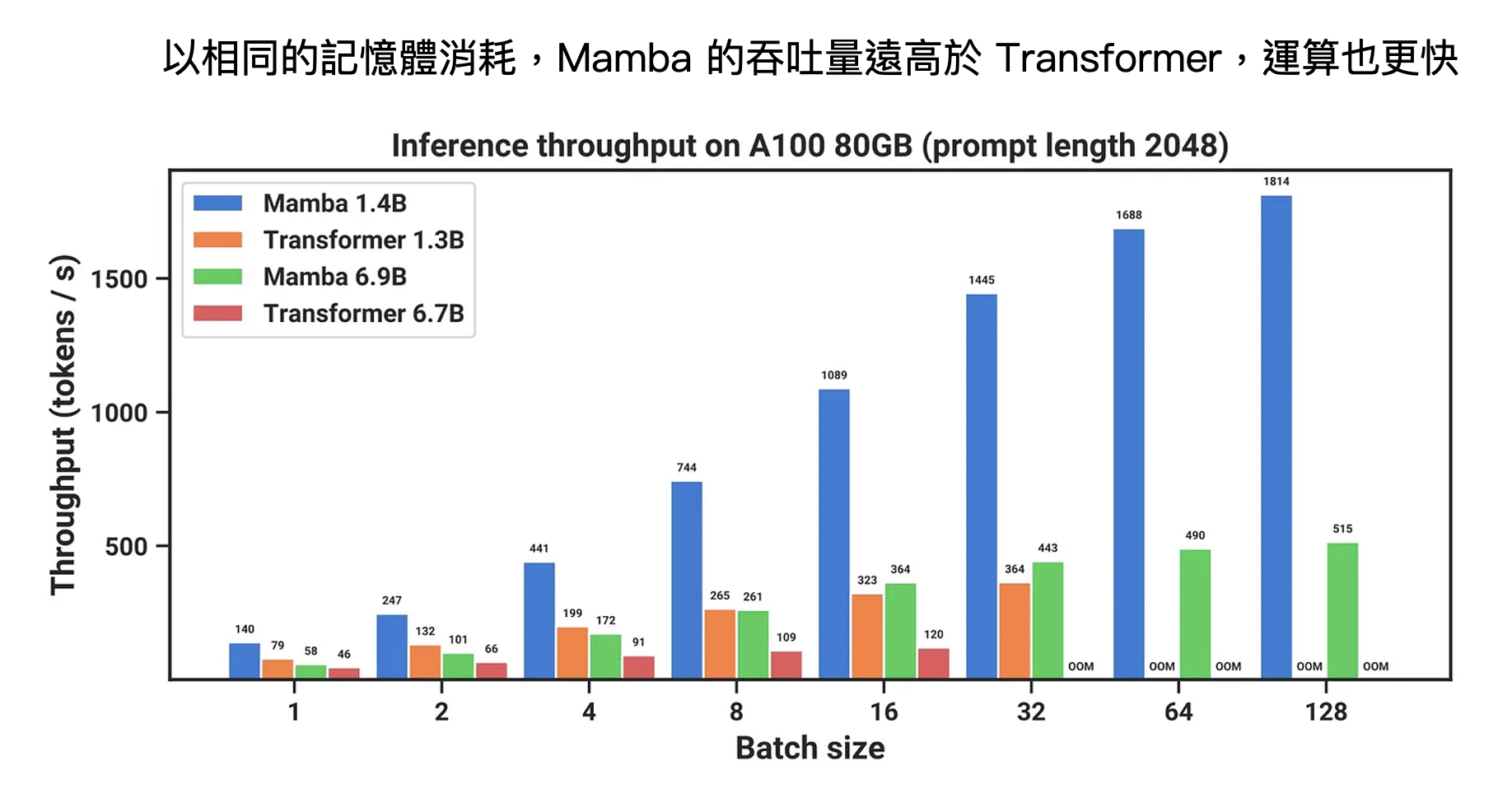

- Mamba 架構解決過去 Transformer 推論成本過高的痛點,可在相同表現水準下有效節省記憶體資源。

- 透過 SSM 的篩選機制兼顧模型的效率及有效性,可過濾數據品質並增強對序列處理的精準度。

- 判斷未來 3-5 年仍為大幅採購算力的時代,然預期未來 AI 領域的應用將隨 Mamba 的出現而加速進展,且能為企業有效地減少運算成本。

Mamba 擅長處理長序列問題,推論速度可較 Transformer 快五倍

自 Google 在 2017 年推出 Transformer 架構,過去六年裡 Transformer 一直在深度學習領域中佔據主導地位,但其缺點是隨著文字序列的增長,所需的記憶體和推論成本會成平方增長(即序列長度加倍,計算成本就增加四倍),導致它無法有效地處理太長的文本與高解析度的圖像。

而 Mamba 架構正是解決了此痛點,Mamba 是第一個可達到 Transformer 水準且屬於線性時間序列的模型(Linear-Time Sequence Model ),計算複雜度只會隨著輸入序列長度增加成線性增長而非指數型增長,除了可以在非常長的序列下進行高效建模,在相同資料量下,推論速度可比 Transformer 快五倍,可以較低成本達到與 Transformer 相同的表現水準。

對於長序列的處理,Transformer 和 Mamba 採用不同的方法:Transformer 選擇透過更複雜的注意力機制來處理長序列問題,而 Mamba 則是透過選擇性狀態空間(SSM, Selective State Space Model),這種架構可以以更少的算力,達到比 Transformer 架構更高的生成效果。因此,Mamba 透過 SSM 來處理序列,可實現更快的推理,並隨序列長度線性擴展達到更高的效能。

Source:《Mamba: Linear-Time Sequence Modeling with Selective State Spaces》、富果研究部

透過 Mamba 架構可實現更快的運算並減少記憶體需求,同時兼顧效率及有效性

過去,Transformer 模型使用的注意力機制會將每個 token 的狀態都儲存在 Transformer 中,這導致無法有效地壓縮文本,因此

需要長時間進行訓練,效率低下。而早期的 RNN(註)模型則會將狀態壓縮在單一變數中,同樣地,這種做法也限制了 RNN 的表現和有效性。這兩種模型都面臨著效率和有效性之間的取捨。因此,Mamba 架構旨在通過新的模型來同時兼顧效率和有效性。

一個有效的模型需要具有少量的狀態,同時又能包含所有必要的資訊。如果有一個模型能夠有效地壓縮這些資訊,就能使模型既高效又具有有效性。因此,Mamba 架構通過 SSM 模型的線性時間序列特性實現了效率(平行化處理可以提高效率,有助於縮短模型訓練時間),同時通過新增的篩選機制(Selection Mechanism)有效地選擇必要的資訊。這種設計使得 Mamba 能夠在處理大規模文本和數據時取得出色的表現,同時提高了計算效率和模型的有效性。

註:RNN 是一種循環神經網絡,類似於人類的思維方式,它具有記憶功能,可以處理序列數據,如語言、時間序列等。簡單來說,它的設計是為了處理序列中的每個元素,並將上一步的輸出作為下一步的輸入。這使得 RNN …

閱讀進度